Phần 1: Kafka Là Gì? Tại Sao Nó Lại Quan Trọng Đến Vậy?

Kafka là gì?

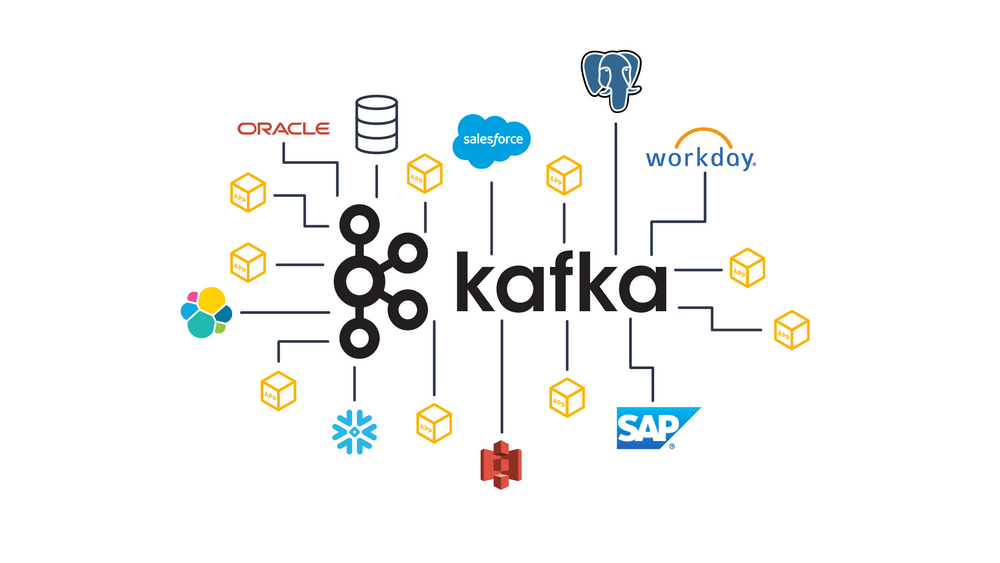

Apache Kafka là một nền tảng phân tán truyền phát sự kiện (distributed event streaming platform) mã nguồn mở. Nói một cách đơn giản, hãy tưởng tượng Kafka như một hệ thống bưu điện siêu tốc và siêu tin cậy cho dữ liệu:

- Sự kiện (Event): Bất cứ điều gì xảy ra mà bạn muốn ghi nhận. Đó có thể là một giao dịch mua hàng, một lượt xem trang, một cập nhật trạng thái đơn hàng, một chỉ số từ cảm biến, v.v. Trong Kafka, những sự kiện này được gọi là records hoặc messages.

- Truyền phát (Streaming): Khả năng xử lý các sự kiện này một cách liên tục, theo thời gian thực, ngay khi chúng được tạo ra.

- Phân tán (Distributed): Kafka được thiết kế để chạy trên một cụm (cluster) gồm nhiều máy chủ, giúp nó có khả năng chịu lỗi cao và dễ dàng mở rộng.

Kafka ban đầu được phát triển tại LinkedIn để giải quyết các vấn đề về theo dõi hoạt động người dùng và thu thập log với quy mô lớn. Sau đó, nó được mã nguồn mở và nhanh chóng trở thành một dự án hàng đầu của Apache Software Foundation.

Mục đích cốt lõi của Kafka là cung cấp một nền tảng cho phép các ứng dụng có thể:

- Xuất bản (Publish) và Đăng ký (Subscribe) các luồng sự kiện.

- Lưu trữ (Store) các luồng sự kiện một cách bền bỉ và tin cậy trong khoảng thời gian mong muốn.

- Xử lý (Process) các luồng sự kiện theo thời gian thực hoặc theo lô (batch).

Tại sao Kafka lại quan trọng?

Sự phổ biến của Kafka không phải là ngẫu nhiên. Nó giải quyết được nhiều vấn đề cố hữu trong việc xây dựng các hệ thống dữ liệu lớn và phức tạp:

- Découpage (Tách rời hệ thống): Kafka hoạt động như một lớp trung gian giữa các hệ thống tạo ra dữ liệu (Producers) và các hệ thống tiêu thụ dữ liệu (Consumers). Producers không cần biết Consumers là ai và ngược lại. Điều này giúp các thành phần trong hệ thống trở nên độc lập, dễ bảo trì, nâng cấp và mở rộng hơn.

- Khả năng chịu lỗi và Độ bền cao (Fault Tolerance & Durability): Dữ liệu trong Kafka được phân vùng và sao chép (replicated) trên nhiều máy chủ trong cụm. Nếu một máy chủ gặp sự cố, dữ liệu vẫn an toàn và hệ thống vẫn có thể tiếp tục hoạt động.

- Thông lượng cực cao (High Throughput): Kafka có khả năng xử lý hàng trăm ngàn, thậm chí hàng triệu tin nhắn mỗi giây. Điều này rất quan trọng đối với các ứng dụng có lượng dữ liệu lớn và tốc độ cao.

- Khả năng mở rộng linh hoạt (Scalability): Bạn có thể dễ dàng mở rộng cụm Kafka bằng cách thêm các máy chủ (brokers) mới khi nhu cầu tăng lên, cả về khả năng lưu trữ lẫn khả năng xử lý.

- Xử lý dữ liệu theo thời gian thực (Real-time Processing): Kafka có độ trễ rất thấp, cho phép các ứng dụng xây dựng trên nó có thể phản ứng nhanh chóng với các sự kiện mới xảy ra.

- Lưu trữ bền vững (Durable Storage): Khác với nhiều hệ thống message queue truyền thống chỉ giữ tin nhắn cho đến khi được tiêu thụ, Kafka có thể lưu trữ dữ liệu trong một khoảng thời gian dài (có thể cấu hình, thậm chí là vĩnh viễn). Điều này cho phép các consumer xử lý lại dữ liệu hoặc các consumer mới tham gia sau này vẫn có thể đọc được dữ liệu lịch sử.

- Nền tảng cho Kiến trúc hướng sự kiện (Event-Driven Architecture – EDA): Kafka là công cụ lý tưởng để xây dựng các hệ thống theo mô hình EDA, nơi các thành phần giao tiếp với nhau thông qua các sự kiện.

Phần 2: Tìm Hiểu Kiến Trúc Và Các Thành Phần Cốt Lõi Của Kafka

Để hiểu rõ hơn về sức mạnh của Kafka, chúng ta cần xem xét kiến trúc và các thành phần chính của nó.

Tổng quan kiến trúc

Kafka hoạt động như một cụm (cluster) gồm một hoặc nhiều máy chủ, mỗi máy chủ được gọi là một broker. Các broker này phối hợp với nhau để quản lý việc lưu trữ và truyền tải dữ liệu.

Trong quá khứ, Kafka phụ thuộc vào Apache ZooKeeper để quản lý metadata của cluster (thông tin về brokers, topics, partitions, leader election…). Tuy nhiên, các phiên bản Kafka mới hơn đang dần chuyển sang sử dụng KRaft (Kafka Raft metadata mode), một giao thức đồng thuận dựa trên Raft được tích hợp sẵn, giúp loại bỏ sự phụ thuộc vào ZooKeeper và đơn giản hóa kiến trúc.

Các thành phần và khái niệm cốt lõi

- Events/Messages/Records (Sự kiện/Tin nhắn/Bản ghi):

- Đây là đơn vị dữ liệu cơ bản trong Kafka.

- Mỗi sự kiện thường bao gồm một key (khóa), một value (giá trị), một timestamp (dấu thời gian), và có thể có thêm headers (metadata tùy chọn).

- Key là một phần quan trọng, thường được sử dụng để quyết định sự kiện sẽ được gửi vào partition nào, đảm bảo các sự kiện có cùng key sẽ luôn vào cùng một partition và được xử lý theo thứ tự.

- Value chính là nội dung của sự kiện (ví dụ: JSON, Avro, Protobuf, hoặc chuỗi văn bản).

- Producers (Bên gửi/Nhà sản xuất):

- Là các ứng dụng hoặc tiến trình có nhiệm vụ gửi (publish) các luồng sự kiện đến các topics trong Kafka.

- Producer tự quyết định gửi sự kiện vào partition nào của topic. Nếu có key, nó sẽ được hash để chọn partition. Nếu không có key, Producer có thể gửi theo cơ chế round-robin hoặc một logic tùy chỉnh.

- Consumers (Bên nhận/Người tiêu dùng):

- Là các ứng dụng hoặc tiến trình đăng ký (subscribe) để đọc và xử lý các luồng sự kiện từ các topics.

- Consumers đọc dữ liệu theo thứ tự mà chúng được ghi vào trong mỗi partition.

- Consumer Groups (Nhóm Consumer):

- Một hoặc nhiều consumers có thể cùng làm việc như một nhóm để tiêu thụ dữ liệu từ một hoặc nhiều topics.

- Kafka đảm bảo rằng mỗi bản ghi trong một partition chỉ được xử lý bởi một consumer duy nhất trong một consumer group tại một thời điểm.

- Điều này cho phép xử lý song song và cân bằng tải (load balancing) việc tiêu thụ dữ liệu. Nếu một consumer trong nhóm gặp sự cố, các partitions mà nó đang xử lý sẽ được gán lại cho các consumer khác trong cùng nhóm.

- Brokers (Máy chủ Kafka):

- Là các máy chủ riêng lẻ trong cụm Kafka.

- Mỗi broker lưu trữ một số partitions của các topics.

- Chịu trách nhiệm nhận tin nhắn từ Producers, lưu trữ chúng, và phục vụ yêu cầu đọc từ Consumers.

- Quản lý việc sao chép (replication) dữ liệu giữa các broker để đảm bảo tính sẵn sàng cao.

- Topics (Chủ đề):

- Là một danh mục hoặc tên luồng (feed name) mà các sự kiện được gửi đến và được Consumers đăng ký.

- Ví dụ về topics:

user_clicks,order_updates,payment_transactions,sensor_data. - Topics trong Kafka luôn là multi-producer và multi-subscriber; tức là, một topic có thể có không, một hoặc nhiều producer ghi dữ liệu vào nó, cũng như không, một hoặc nhiều consumer group đọc dữ liệu từ nó.

- Partitions (Phân vùng):

- Mỗi topic được chia thành một hoặc nhiều partitions. Partitions là đơn vị cơ bản của tính song song và khả năng mở rộng trong Kafka.

- Các sự kiện trong một partition được lưu trữ theo thứ tự chúng được ghi vào và được gán một ID tuần tự, không thay đổi gọi là offset.

- Việc chia topic thành nhiều partitions cho phép:

- Phân tán dữ liệu: Dữ liệu của một topic có thể được trải rộng trên nhiều broker trong cluster.

- Tăng thông lượng: Nhiều producer có thể ghi vào các partition khác nhau của cùng một topic, và nhiều consumer (trong cùng một group) có thể đọc từ các partition khác nhau một cách song song.

- Số lượng partitions cho một topic được cấu hình khi tạo topic và có thể tăng lên sau đó (nhưng không thể giảm).

- Offsets (Vị trí/Chỉ mục):

- Là một số nguyên tuần tự, duy nhất, xác định vị trí của mỗi sự kiện trong một partition cụ thể.

- Consumers theo dõi offset của sự kiện cuối cùng mà chúng đã xử lý thành công cho mỗi partition. Thông tin này (offset đã commit) thường được lưu trữ trong một topic nội bộ của Kafka (tên là

__consumer_offsets) hoặc một hệ thống lưu trữ bên ngoài. - Việc theo dõi offset cho phép consumer dừng lại và khởi động lại mà không làm mất dữ liệu hoặc xử lý lại dữ liệu không cần thiết.

- Replication (Sao chép):

- Để đảm bảo tính sẵn sàng cao và khả năng chịu lỗi, mỗi partition có thể được sao chép (replicated) trên nhiều broker.

- Đối với mỗi partition, một broker sẽ được bầu làm leader và các broker khác chứa bản sao (replicas) sẽ đóng vai trò là followers.

- Tất cả các yêu cầu đọc và ghi cho một partition đều đi qua leader. Followers đồng bộ dữ liệu từ leader.

- Nếu broker leader của một partition gặp sự cố, một trong các followers sẽ tự động được bầu làm leader mới, đảm bảo dữ liệu vẫn có sẵn. Số lượng bản sao (replication factor) được cấu hình cho mỗi topic.

Luồng dữ liệu cơ bản trong Kafka

- Producers gửi (publish) các sự kiện đến một topic cụ thể. Producer có thể chỉ định key để đảm bảo các sự kiện liên quan đến cùng một thực thể (ví dụ: cùng một user ID) luôn đi vào cùng một partition.

- Broker (leader của partition đó) nhận sự kiện, ghi nó vào cuối partition và gán cho nó một offset duy nhất. Sau đó, sự kiện được sao chép sang các broker follower.

- Consumers (thuộc một consumer group) đăng ký (subscribe) vào topic đó. Kafka sẽ phân phối các partitions của topic cho các consumers trong group.

- Mỗi consumer đọc các sự kiện từ các partitions được gán cho nó, theo thứ tự offset. Consumer theo dõi offset của sự kiện cuối cùng nó đã xử lý và “commit” offset đó trở lại Kafka.

Phần 3: Các Trường Hợp Sử Dụng Phổ Biến Và Lợi Ích Vượt Trội Của Kafka

Với kiến trúc mạnh mẽ và linh hoạt, Kafka đã trở thành một công cụ không thể thiếu trong nhiều lĩnh vực và trường hợp sử dụng khác nhau.

Các trường hợp sử dụng điển hình

- Hệ thống nhắn tin (Messaging System):

- Thay thế các message broker truyền thống như RabbitMQ, ActiveMQ trong các trường hợp cần thông lượng cao hơn, khả năng lưu trữ bền vững và khả năng mở rộng tốt hơn. Kafka thường được dùng để découpage các microservices, cho phép chúng giao tiếp bất đồng bộ.

- Theo dõi hoạt động Website/Ứng dụng (Website/Application Activity Tracking):

- Đây là trường hợp sử dụng ban đầu của Kafka tại LinkedIn. Thu thập hành vi người dùng (lượt xem trang, click, tìm kiếm, thời gian tương tác) theo thời gian thực. Dữ liệu này sau đó được sử dụng cho phân tích, cá nhân hóa, gợi ý sản phẩm, giám sát, v.v.

- Thu thập và Tổng hợp Log (Log Aggregation):

- Thu thập log từ nhiều ứng dụng, máy chủ và dịch vụ khác nhau vào một nơi tập trung (Kafka). Điều này giúp đơn giản hóa việc tìm kiếm, phân tích, gỡ lỗi và giám sát hệ thống. Các công cụ như Fluentd, Logstash có thể được sử dụng để đẩy log vào Kafka.

- Xử lý Luồng (Stream Processing):

- Kafka là nền tảng lý tưởng để xây dựng các ứng dụng xử lý luồng dữ liệu theo thời gian thực. Các sự kiện được xử lý ngay khi chúng đến, cho phép thực hiện các tác vụ như phân tích, biến đổi, làm giàu dữ liệu, phát hiện gian lận, cảnh báo tức thời.

- Kafka tích hợp tốt với các framework xử lý luồng mạnh mẽ như:

- Kafka Streams: Một thư viện client cho phép xây dựng các ứng dụng và microservices xử lý luồng trực tiếp, sử dụng chính Kafka làm cơ sở hạ tầng.

- ksqlDB: Một công cụ cơ sở dữ liệu sự kiện cho phép bạn xây dựng các ứng dụng xử lý luồng bằng các câu lệnh SQL quen thuộc trên dữ liệu từ Kafka.

- Apache Flink, Apache Spark Streaming, Apache Samza: Các framework xử lý luồng phân tán mạnh mẽ khác cũng thường sử dụng Kafka làm nguồn dữ liệu đầu vào và/hoặc đầu ra.

- Nguồn Sự kiện (Event Sourcing):

- Trong mô hình Event Sourcing, tất cả các thay đổi trạng thái của một ứng dụng được ghi lại dưới dạng một chuỗi các sự kiện bất biến. Kafka đóng vai trò là một kho lưu trữ sự kiện (event store) tin cậy, có thứ tự và khả năng chịu lỗi cao cho kiến trúc này.

- Thu thập Số liệu (Metrics Collection):

- Thu thập các số liệu hoạt động (operational metrics) từ các ứng dụng và hệ thống phân tán (ví dụ: CPU, memory, request latency). Dữ liệu này sau đó được đưa vào các hệ thống giám sát (như Prometheus, Grafana) hoặc hệ thống cảnh báo.

- Commit Log cho Hệ thống Phân tán:

- Do tính chất bền bỉ và có thứ tự, Kafka có thể được sử dụng như một commit log để đồng bộ hóa trạng thái hoặc sao chép dữ liệu giữa các node trong một hệ thống phân tán.

Lợi ích chính khi sử dụng Kafka (Tóm tắt)

- Thông lượng cao (High Throughput): Xử lý hàng triệu sự kiện mỗi giây.

- Khả năng mở rộng (Scalability): Dễ dàng mở rộng theo chiều ngang bằng cách thêm brokers và tăng số partitions.

- Độ bền và Chịu lỗi (Durability and Fault Tolerance): Dữ liệu được sao chép an toàn, hệ thống vẫn hoạt động ngay cả khi có broker gặp sự cố.

- Độ trễ thấp (Low Latency): Xử lý sự kiện gần như thời gian thực (thường là mili giây).

- Découpage hệ thống (Decoupling): Producers và Consumers hoạt động độc lập, tăng tính linh hoạt và khả năng bảo trì.

- Lưu trữ sự kiện (Event Storage): Khả năng lưu trữ sự kiện lâu dài, cho phép xử lý lại hoặc các kịch bản “time travel”.

- Hệ sinh thái phong phú (Rich Ecosystem):

- Kafka Connect: Một framework mạnh mẽ để dễ dàng tích hợp Kafka với các hệ thống nguồn (databases, message queues) và hệ thống đích (data warehouses, search indexes, cloud storage) mà không cần viết nhiều code.

- Kafka Streams & ksqlDB: Cung cấp các công cụ mạnh mẽ để xây dựng ứng dụng xử lý luồng trực tiếp trên Kafka.

- Cộng đồng người dùng và nhà phát triển lớn mạnh, cùng nhiều công cụ hỗ trợ từ bên thứ ba.

Kết luận

Nếu bạn đang đối mặt với những thách thức về việc xử lý luồng dữ liệu lớn, xây dựng các hệ thống phản ứng nhanh hoặc muốn hiện đại hóa kiến trúc dữ liệu của mình, thì việc tìm hiểu và cân nhắc Apache Kafka chắc chắn là một lựa chọn đáng giá.